Anthropic noteikumu mērķis ir aizliegt izmantot Claude, lai izveidotu bioloģiskus, ķīmiskus, radioloģiskus un kodolieročus (CBRN).

Mākslīgā intelekta (MI) uzņēmums ir atjauninājis Claude AI robota lietošanas politiku. Papildus striktāku kiberdrošības noteikumu ieviešanai, Anthropic izskaidro bīstamos ieročus, ko cilvēkiem nebūtu jāveido.

Lai gan pats uzņēmums īpaši neizceļ noteikumus par ieročiem, tos var manīt, salīdzinot lapas iepriekšējo un jauno politiku. Tāpat kā senāk, tur joprojām tiek minēts, ka Claude nevar izmantot ieroču izgatavošanai, bet tagad to papildina piebildes par to veidiem.

Maijā ražotājs ieviesa ‘’AI Safety Level 3’’ aizsardzību papildus savam Claude Opus 4 modelim. Drošības mēri ir veidoti, lai apgrūtinātu modeļa uzlaušanu, kā arī liegtu tā izmantošanu CBRN ieroču izgatavošanai.

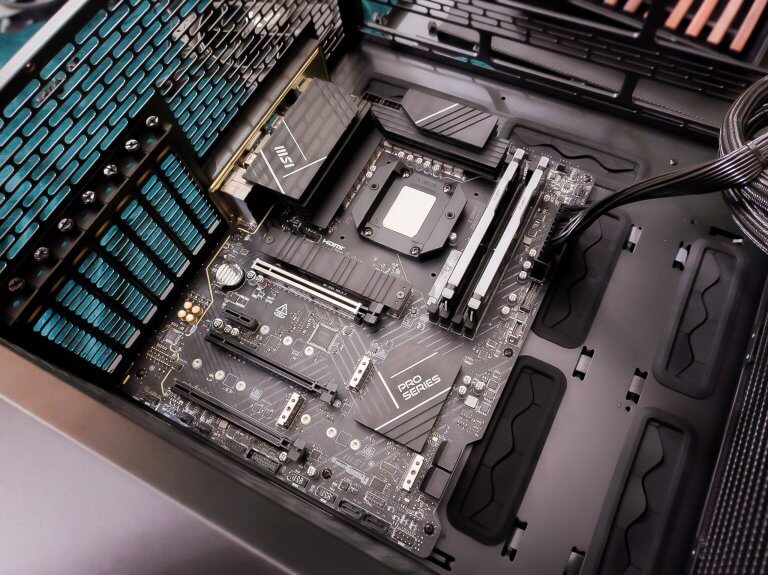

Publikācijā uzņēmums arī apzinās MI aģentu rīku potenciālos riskus, tostarp Computer Use, kas ļauj Claude pārņemt datoru. Kā arī Claude Code, kas integrē Claude izstrādātāja terminālī. “Šīs jaudīgās spējas ievieš jaunus riskus, tostarp mērogotas ļaunprātīgas izmantošanas, ļaunprogrammatūras izveides un kiberuzbrukumu potenciālu.”

MI uzņēmums atbild uz riskiem, ieviešot jaunu ‘’Do Not Compromise Computer or Network Systems’’ daļu savā lapā. Tur izklāstīti noteikumi pret Claude izmantošanu, lai pētītu vai izmantotu ievainojamības; izveidotu un izplatītu ļaunprogrammatūru; izstrādātu rīkus pakalpojuma atteikuma uzbrukumiem un citiem mērķiem.

Papildus Anthropic atvieglina noteikumus ap politisko saturu. Tā vietā, lai liegtu jebkāda veida politiskā satura izveidi, tagad uzņēmums liedz to darīt “gadījumos, kas ir maldinoši vai traucē demokrātiskajiem procesiem, vai ietver vēlētāju un kampaņu mērķauditorijas atlasi.”

Avots: TheVerge