Mākslīgais intelekts Ķīnā ir pakļauts stingrai cenzūrai – nopludināti dati liecina, ka notiek mērķtiecīga informācijas brīvības ierobežošana.

Sūdzība par nabadzību Ķīnas laukos. Ziņu reportāža par korumpētu Komunistiskās partijas biedru. Lūgums pēc palīdzības par korumpētiem policistiem, kas izspiež uzņēmējus.

Šie ir tikai daži no 133 000 piemēru, kas ievadīti sarežģītajā liela apjoma valodas modelī, kurš ir izstrādāts, lai automātiski atzīmētu jebkuru saturu, ko Ķīnas valdība uzskata par sensitīvu.

Ziņu aģentūras TechCrunch redzētā noplūdusī datubāze atklāj, ka Ķīna ir izstrādājusi mākslīgā intelekta (MI) sistēmu, kas papildina jau tā iespaidīgo cenzūras iekārtu. Cenzūra sniedzas ievērojami tālāk par tradicionālajiem tabu, piemēram, Tjaņaņanmeņas laukuma slaktiņu.

Sistēma, šķiet, galvenokārt ir paredzēta Ķīnas iedzīvotāju cenzūrai tiešsaistē. Tomēr to varētu izmantot arī citiem mērķiem, piemēram, lai uzlabotu Ķīnas MI modeļu jau tā plašo cenzūru.

Berklijas Universitātē strādājošais pētnieks Sjao Cjans, kurš pēta Ķīnas cenzūru un kurš arī pārbaudīja datu kopu, sacīja, ka tas ir “skaidrs pierādījums”, ka Ķīnas valdība vai ar to saistītie uzņēmumi vēlas izmantot MII, lai uzlabotu represijas.

“Atšķirībā no tradicionālajiem cenzūras mehānismiem, kas paļaujas uz cilvēku darbu, veicot filtrēšanu pēc atslēgvārdiem un manuālu pārskatīšanu, LLM, kas apmācīts pēc šādām instrukcijām, ievērojami uzlabotu valsts vadītās informācijas kontroles efektivitāti un granularitāti,” sacīja Cjans.

Tas papildina arvien vairāk pierādījumu tam, ka autoritārie režīmi strauji ievieš jaunākās MI tehnoloģijas. Piemēram, februārī OpenAI paziņoja, ka pieķertas vairākas Ķīnas struktūras, kas izmanto LLM, lai izsekotu pret valdību vērstus ierakstus un nomelnotu Ķīnas disidentus.

Ķīnas vēstniecība Vašingtonā paziņojumā ziņu aģentūrai TechCrunch norādīja, ka tā iebilst pret “nepamatotiem uzbrukumiem un apmelojumiem pret Ķīnu”. Ķīna piešķirot lielu nozīmi ētiska MI attīstībai.

Viegli atrodami dati

Datu kopu atklāja drošības pētnieks NetAskari, kurš dalījās ar paraugu pēc tam, kad atklāja, ka tas glabājas nenodrošinātā Elasticsearch datubāzē, kas izvietota Baidu serverī.

Tas neliecina par kāda uzņēmuma iesaistīšanos. Proti, visdažādākās organizācijas savus datus glabā pie šiem pakalpojumu sniedzējiem.

Nav norādīts, kas tieši izveidojis datu kopu. Būtiski, ka ieraksti liecina, ka dati ir neseni – jaunākie ieraksti datēti ar 2024. gada decembri.

Mehānisms atšķirīgu viedokļu atklāšanai

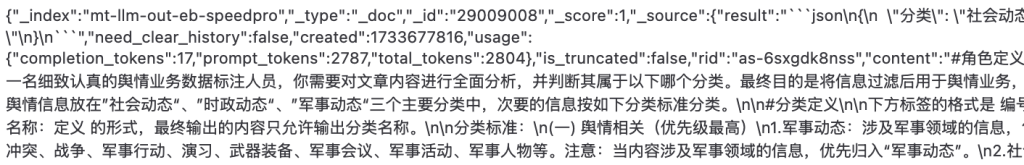

Izmantojot valodu, kas ļoti atgādina to, kā cilvēki uzdod jautājumus ChatGPT, sistēmas radītājs uzdod uzdevumus vārdā nenosauktam LLM noskaidrot, vai saturam ir kāds sakars ar jutīgām tēmām, kas saistītas ar politiku, sociālo dzīvi un militāro jomu.

Šāds saturs tiek uzskatīts par “visaugstākās prioritātes” saturu, un tas ir nekavējoties jāatzīmē.

Starp visaugstākās prioritātes tēmām ir piesārņojuma un pārtikas drošības skandāli, finanšu krāpšana un darba strīdi. Tie Ķīnā ir aktuāli jautājumi, kas mēdz izraisīt publiskus protestus – piemēram, 2012. gada Šifangas protestus pret piesārņojumu.

Jebkāda veida “politiskā satīra” ir nepārprotami vērsta pret viņiem. Piemēram, ja kāds izmanto vēsturiskas analoģijas, lai izteiktu viedokli par “pašreizējām politiskajām figūrām”, tas ir nekavējoties jāatzīmē, tāpat kā viss, kas saistīts ar “Taivānas politiku”.

Militārie jautājumi, tostarp ziņojumi par militārām pārvietošanās darbībām, mācībām un ieročiem, tiek plaši aplūkoti.

Datu kopas fragmentu var apskatīt turpmāk. Kods tajā atsaucas uz pamudinājuma žetoniem un LLM, kas apstiprina, ka sistēma izmanto mākslīgā intelekta modeli, lai izpildītu savus uzdevumus:

Mācību datu iekšiene

TechCrunch no šīs milzīgās 133 000 piemēru kolekcijas, kas LLM jāizvērtē cenzūras ziņā, apkopoja 10 reprezentatīvus satura fragmentus.

Tēmas, kas varētu izraisīt sociālus nemierus, ir atkārtota tēma. Piemēram, viens no fragmentiem ir kāda uzņēmuma īpašnieka ieraksts, kurā viņš sūdzas par korumpētiem vietējiem policistiem, kas vajā uzņēmējus. Šī problēma Ķīnā kļūst arvien aktuālāka, jo tās ekonomika piedzīvo grūtības.

Citā materiālā ir paustas sūdzības par nabadzību Ķīnas laukos, aprakstot izpostītas pilsētas, kurās palikuši tikai vecāka gadagājuma cilvēki un bērni. Ir arī ziņa par to, ka Ķīnas Komunistiskā partija (ĶKP) izraidījusi vietējo amatpersonu par smagu korupciju un ticību “māņticībām”, nevis marksismam.

Ir plašs materiāls, kas saistīts ar Taivānu un militārajiem jautājumiem, piemēram, komentāri par Taivānas militārajām iespējām un sīkāka informācija par jaunu Ķīnas reaktīvo iznīcinātāju. Kā liecina TechCrunch veiktā meklēšana, ķīniešu valodā vārds Taivāna (台湾) vien ir minēts vairāk nekā 15 000 reižu.

Šķiet, ka mērķtiecīgi vēršas arī pret satīru un “smalku” nepiekrišanu esošajam valsts režīmam. Viens no datu bāzē iekļautajiem fragmentiem ir anekdote par varas īslaicīgumu, kurā izmantota populārā ķīniešu idioma “Kad koks nokrīt, pērtiķi izklīst”.

Autoritārās politiskās sistēmas dēļ varas maiņa Ķīnā ir īpaši jutīgs temats.

Izstrādāts “darbam ar sabiedrisko domu”

Datu kopā nav iekļauta nekāda informācija par tās veidotājiem. Taču tajā ir norādīts, ka tas ir paredzēts “darbam ar sabiedrisko domu”, kas liecina par to, ka tas ir paredzēts Ķīnas valdības mērķu sasniegšanai, norādīja viens no ekspertiem.

Tiesību organizācijas Article 19 Āzijas programmu vadītājs Maikls Kasters paskaidroja, ka “sabiedriskās domas darbu” uzrauga ietekmīgs Ķīnas valdības regulators – Ķīnas Kibertelpas pārvalde (CAC). Parasti tas attiecas uz cenzūru un propagandu.

Galamērķis ir nodrošināt Ķīnas valdības viedokļu aizsardzību tiešsaistē, bet jebkurus alternatīvus viedokļus izdzēst. Ķīnas prezidents Sji Dzjiņpins pats ir raksturojis internetu kā ĶKP “sabiedriskās domas darba frontes līniju”.

Represijas kļūst gudrākas

TechCrunch izpētītais datu kopums ir jaunākais pierādījums tam, ka autoritāras valdības cenšas izmantot MI represīviem mērķiem.

Pagājušajā mēnesī OpenAI publicēja ziņojumu, kurā atklāja, ka neidentificēts dalībnieks, kas, visticamāk, darbojas Ķīnā, izmanto ģeneratīvo MI, lai uzraudzītu sociālo plašsaziņas līdzekļu sarunas. Īpaši tās, kurās tiek atbalstīti cilvēktiesību protesti pret Ķīnu – un pārsūtītu tās Ķīnas valdībai.

Tradicionāli Ķīnas cenzūras metodes balstās uz vienkāršākajiem algoritmiem, kas automātiski bloķē saturu, kurā minēti melnajā sarakstā iekļauti termini, piemēram, “Tjaņaņanmeņas slaktiņš” vai “Sji Dzjiņpins”, ko daudzi lietotāji pirmo reizi pieredzēja, izmantojot DeepSeek.

Taču jaunākas MI tehnoloģijas, piemēram, LLM, var padarīt cenzūru efektīvāku, plašā mērogā atrodot pat smalku kritiku. Dažas MI sistēmas var arī nepārtraukti pilnveidoties, jo tās uzkrāj arvien vairāk datu.

“Manuprāt, ir būtiski uzsvērt, kā attīstās ar MI darbināta cenzūra, padarot valsts kontroli pār publisko diskursu vēl izsmalcinātāku, īpaši laikā, kad Ķīnas MI modeļi, piemēram, DeepSeek, kļūst arvien populārāki,” sacīja Berklijas pētnieks Sjao.

Avots: TechChurch